La Comisión Europea ha presentado este miércoles su propuesta para regular la Inteligencia Artificial en la Unión Europea de manera que se impulse su desarrollo y anime a la inversión e investigación, pero fijando altos estándares de seguridad y derechos fundamentales para evitar que se use con fines represivos, de manipulación o discriminatorios.

La Comisión Europea ha presentado este miércoles su propuesta para regular la Inteligencia Artificial en la Unión Europea de manera que se impulse su desarrollo y anime a la inversión e investigación, pero fijando altos estándares de seguridad y derechos fundamentales para evitar que se use con fines represivos, de manipulación o discriminatorios.

Bruselas tiene claro que deben quedar prohibidas en todo caso aplicaciones de «puntuación social», como el sistema de «crédito social» que utiliza China para vigilar a sus ciudadanos, o mecanismos de manipulación de la voluntad, por ejemplo instalados en juguetes con asistente de voz para incitar al menor a comportamientos peligrosos.

Se trata de sistemas que suponen un «riesgo inadmisible» para la seguridad o para los derechos fundamentales de las personas, según han explicado en una rueda de prensa conjunta la vicepresidenta del Ejecutivo comunitario responsable de Competencia, Margrethe Vestager, y el comisario de Industria y Mercado Interior, Thierry Breton.

Las nuevas reglas tienen que ser aún negociadas con los Veintisiete y con el Parlamento europeo, pero el objetivo es que una vez acordadas se apliquen por igual a agentes públicos como privados y a toda entidad europea o extranjera que opere en el mercado interior o su uso afecte a los ciudadanos de la UE.

En el siguiente peldaño de los niveles de riesgo en que la Comisión divide las posibilidades de la inteligencia artificial se sitúan otras opciones que deberían estar «prohibidas en principio», aunque se podrá permitir su uso en circunstancias excepcionales y bajo estrictas condiciones.

En este bloque de sistemas de alto riesgo los servicios comunitarios sitúan, entre otros, el reconocimiento facial indiscriminado en lugares públicos aunque se abre la puerta a su recurso en situaciones excepcionales como la búsqueda de un menor desaparecido o el rastreo de terroristas y otros delincuentes peligrosos.

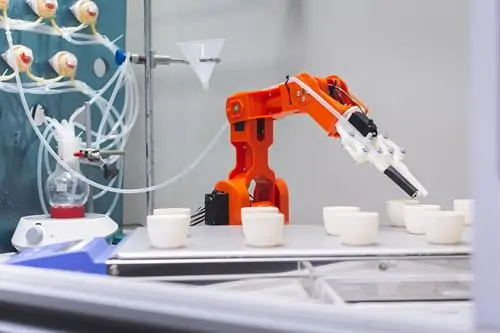

Además se considerarán tecnologías de alto riesgo sometidas a obligaciones y a la supervisión humana aquellas utilizadas en infraestructuras clave como redes de transporte, aprovechadas en componentes de seguridad –cirugía con robots–, en el ámbito educativo o profesional –puntuación de exámenes–, para la gestión del mercado laboral —programas informáticos de clasificación de CV para procedimientos de contratación o migración —verificación de documentos–.

Para estos casos, el Ejecutivo comunitario reclama sistemas de evaluación y control de riesgos, una alta calidad de los datos que alimenten el sistema para evitar resultados discriminatorios y el registro de la actividad para asegurar su trazabilidad.

También se les exigirá documentación detallada sobre el propio sistema y su finalidad para que las autoridades puedan evaluar su conformidad y deberán ofrecer a los usuarios información clara.

Otra de las claves de la propuesta de la Comisión es garantizar la máxima transparencia posible para evitar que los usuarios sean engañados con aplicaciones como el ‘deep fake’ (vídeos manipulados usando técnicas de inteligencia artificial) o los ‘bots’ (programas informáticos que efectúan automáticamente tareas repetitivas a través de Internet).

«Debe quedar clarísimo para el usuario que está hablando con una máquina», ha avisado Vestager, tras alertar de los riesgos para la seguridad y los derechos fundamentales de herramientas que no permiten distinguir con claridad «la realidad de la ficción».

En cualquier caso, Bruselas propone un último nivel de «riesgo mínimo o nulo» en donde asegura que entran la gran mayoría de sistemas de inteligencia artificial y que pueden seguir desarrollándose sin condiciones específicas de seguridad. Es el caso de herramientas como las que filtran los mensajes no deseados en el correo electrónico o las usadas en videojuegos.

Aviso Legal

Esta es la opinión de los internautas, no de diarioabierto.es

No está permitido verter comentarios contrarios a la ley o injuriantes.

Nos reservamos el derecho a eliminar los comentarios que consideremos fuera de tema.

Su direcciónn de e-mail no será publicada ni usada con fines publicitarios.